给大家分享一篇关于互联网和手机的文章。相信很多朋友对互联网和手机还是不太了解,所以边肖也在网上搜集了一些关于手机和互联网的相关知识与大家分享。希望大家看完之后会喜欢。

在本周发表在Arxiv.org预印服务器上的一篇论文中,与谷歌、微软、脸书、卡耐基梅隆大学、多伦多大学、宾夕法尼亚大学和加州大学伯克利分校相关的研究人员提出了Plan2Explore,这是一个自我监控的计划。使用规划来解决以前未知目标的人工智能。研究人员声称,在训练过程中不需要人工监督,即使没有任何特定的任务交互,也能胜过以前的方法。

像Plan2Explore这样的自监督学习算法通过暴露数据部分之间的关系来从数据中生成标签,这与在专家标注的数据集上训练的监督学习算法不同。他们观察世界并与之互动,主要是以与测试无关的方式,就像动物可能观察的那样。图灵奖得主约舒亚本吉奥和扬勒昆认为,自我监控是人类智能的关键,Plan2Explore将其付诸实践——它学会完成新任务,而无需对这些任务进行特殊训练。

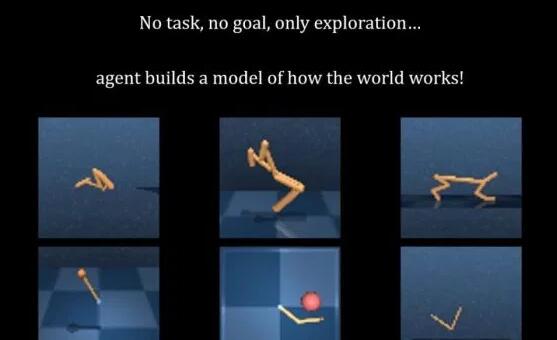

Plan2Explore探索环境,并将其经验总结成一个表示,可以并行预测数千个场景。(一个场景描述了如果代理执行一系列动作会发生什么,例如左转进入走廊,然后穿过房间。给定这个世界模型,Plan2Explore使用DeepMind设计的梦想家来推导其行为。通过预先计划行动的长期结果来预先计划行动的算法。然后,Plan2Explore接收奖励函数(这些函数描述了AI的行为),以适应各种任务,如站立、行走和跑步,与特定任务的交互为零或很少。

为了确保其计算效率,Plan2Explore量化了其各种预测的不确定性。这鼓励系统在具有高不确定性的环境中寻找区域和轨迹,然后使用Plan2Explore来训练区域和轨迹以降低预测不确定性。重复此过程,以便Plan2Explore可以根据自己的预测轨迹进行优化。

在AI agent的仿真性能基准DeepMind Control Suite中的实验中,研究人员表示Plan2Explore无需使用特定目标的信息即可实现其目标——即只使用自我监控的世界模型,与外界没有任何新的交互世界。与以往领先的探索策略相比,Plan2Explore具有更好的性能,有时它是唯一成功的无监督方法。它证明了它的世界模型可以转移到同一个环境中的多个任务。在一个例子中,一个像猎豹一样的代理向后跑,向前翻,向后翻。

“强化学习可以解决复杂的任务;然而,学习通常是针对特定任务的,采样效率仍然是一个挑战。”合著者写道。“通过提出一种能够以可扩展和数据高效的方式学习许多不同任务的有效行为的方法,我们希望这项工作构成了构建可扩展的真实世界强化学习系统的一个步骤。”

GitHub提供了Plan2Explore的代码。

本文就为大家讲解到这里了。标签: